Caso de estudio: all hub content - sistema multi-agente de co-creación visual

- Resultados reales: Generación de textos e imágenes mediante API de Google Gemini.

- Flujos y simulaciones: Orquestación de agentes, gobernanza, métricas de uso y logs de auditoría simulados y validados con usuarios.

- Objetivo estratégico: Validar la experiencia de usuario y la hipótesis de diseño, no construir un MVP.

01

El problema: la crisis del contexto cuantificada

Tiempo perdido por día

Encuesta (n=25)

horas

30% del día productivo

Herramientas en stack promedio

Entrevistas (12 creadores)

apps

Fragmentación cognitiva crónica

Creadores que pierden coherencia

Encuesta

Frustración y retrabajo

Abandono de flujos complejos

Análisis de comportamiento

Ideas y oportunidades perdidas

02

Investigación profunda del usuario

Investigación profunda sobre las frustraciones de los creadores de contenido en ecosistemas digitales fragmentados

2.1. Metodología y herramientas de investigación

- Etnografía digital: Análisis cualitativo de hilos en comunidades online, utilizando Perplexity y Gemini Deep Research para sintetizar discusiones y tendencias.

- Entrevistas cualitativas (10 sesiones): Se llevaron a cabo 10 entrevistas semiestructuradas con un grupo heterogéneo de usuarios. Los perfiles abarcaban desde expertos con altos conocimientos técnicos hasta usuarios completamente no técnicos, garantizando así una visión integral de los retos y necesidades desde múltiples perspectivas.

2.2. Los 5 puntos de dolor principales

Pérdida masiva de productividad por "context switching"

Sobrecarga cognitiva y riesgo de burnout

Fragmentación de herramientas y silos de información

Pérdida de coherencia creativa y de marca

Parálisis por análisis ("choice overload")

2.3. User persona: "la malabarista del contexto"

2.4. La pregunta de diseño correcta (aplicando la navaja de ockham)

❌ Pregunta incorrecta (enfoque técnico)

"¿Cómo podemos construir un sistema para conectar nodos de prompts en secuencia?"

✅ Pregunta correcta (misión de diseño)

"¿Cómo diseñamos un ecosistema donde el contexto de un creador (su brief, su estilo) no sea algo que se introduce repetidamente, sino un activo persistente que guía a un equipo de agentes para producir contenido multimodal que sea siempre on-brand y confiable?"

03

La solución: un prototipo de alta fidelidad

3.1. Alcance del prototipo (real vs. simulado)

Interfaz de Nodos

Validar la usabilidad del lienzo visual.

Generación de Contenido

Validar el impacto de la velocidad (Umbral de Doherty).

Orquestación de Agentes

Validar la claridad del flujo sin construir el backend completo.

Gobernanza y Auditoría

Probar la percepción de confianza y control del usuario.

3.2. Storyboard de la experiencia ideal

El caos creativo

Sara, abrumada, navega entre apps para una sola idea. Es un caso claro de 'Sobrecarga de Opciones' que frenan su creatividad.

El foco

En All Hub Content, su idea está en un solo lugar. Aplicamos la Ley de la Simplicidad con una interfaz limpia que elimina distracciones.

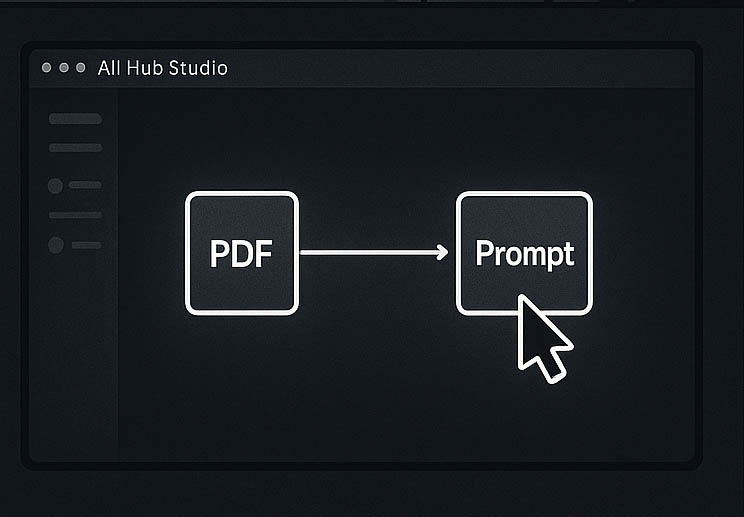

El contexto es el rey

Arrastra el brief al nodo PDF y el sistema lo integra como una sola unidad, aplicando la Ley de la Región Común.

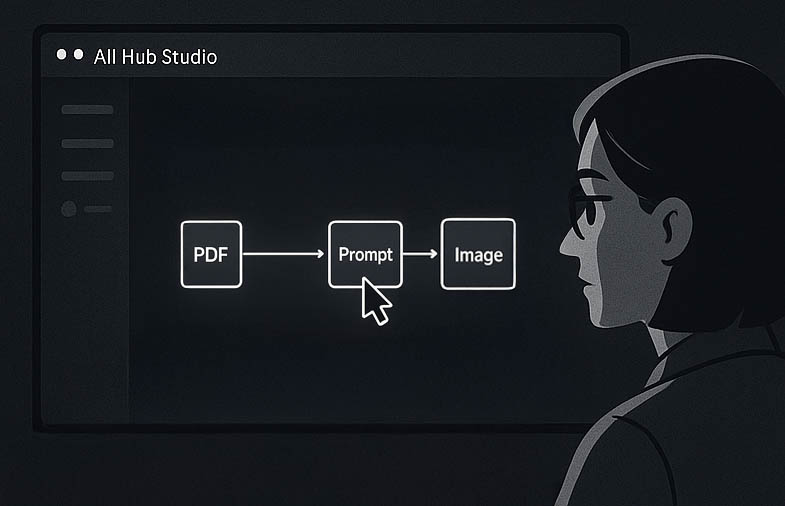

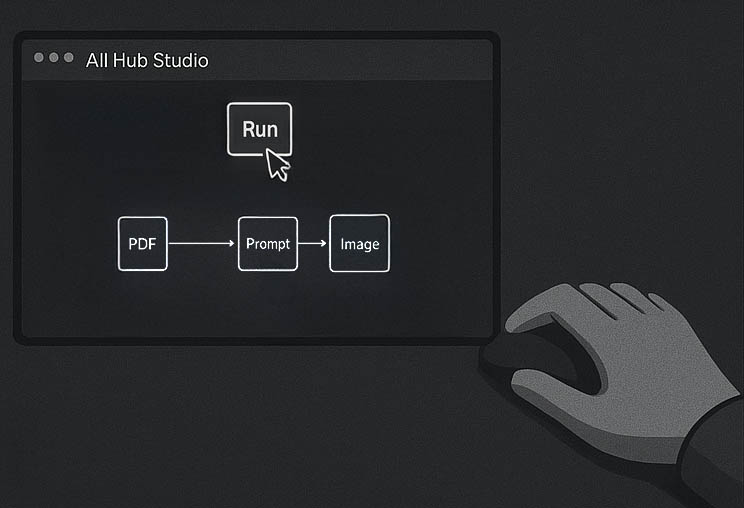

Orquestación visual

Esto aplica la Ley de Conexión Uniforme: al conectar visualmente el prompt con la imagen, se entiende que uno genera al otro.

Comienza la magia

Pulsa 'Generar'. El sistema responde en menos de 0,4s, cumpliendo con el Umbral de Doherty para asegurar fluidez e interacción sin fricción.

La visión materializada

En segundos, el texto y una imagen aparecen. Este es el 'pico' positivo de la experiencia según la Regla del Pico y el Final.

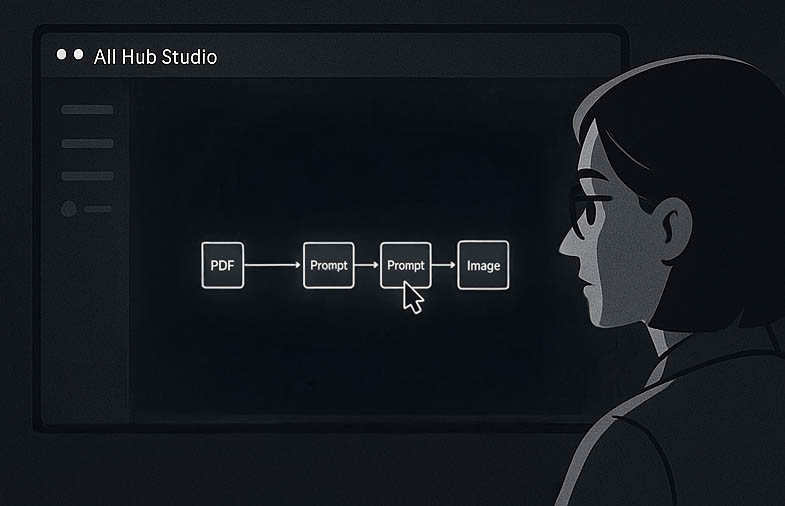

El control creativo

Añade un prompt para ajustar la imagen. La Ley de Conservación de la Complejidad se aplica al transferir la dificultad a una conexión simple.

Creación en estado de flujo

Con un clic, obtiene la imagen perfecta. Al eliminar la fricción, el diseño le ha permitido alcanzar un Estado de Flujo (Flow) creativo.

04

Diseño del sistema: arquitectura y gobernanza

4.1. El equipo de agentes digitales: perfiles de misión

Agente orquestador

"Soy el director del proyecto. Traduzco tu visión en un plan de acción y me aseguro de que el equipo lo ejecute a la perfección."

Construí al Orquestador como el cerebro del sistema utilizando un Playbook de Rutina. Lo diseñé para ser el único punto de contacto con el usuario, interpretando sus intenciones y coordinando al resto del equipo a través de Tools.

Modelo generativo:

Agente analista de contexto

"Convierto el caos informativo de tus briefs en un conocimiento estructurado y listo para usar."

Este agente es un Playbook de Tarea especializado. Lo equipé con una Herramienta de Almacén de Datos para "leer" documentos (RAG). Prioricé la velocidad para una extracción de datos instantánea.

Modelo generativo:

Agente de perfil y memoria

"Recuerdo quién eres y para quién creas, para que nunca tengas que repetirte."

Lo concebí como la memoria persistente del sistema, implementado como un Playbook de Tarea. Invoca una Tool OpenAPI para interactuar con Firestore, recuperando "Brand Kits" y feedback.

Modelo generativo:

Agente creador de copy

"Dame un brief claro y una guía de estilo, y te entregaré un texto que conecta e inspira."

Diseñé a este agente como un Playbook de Tarea especialista y puro. Dado que la creatividad es el núcleo del valor del producto, seleccioné el modelo más avanzado para garantizar el máximo nivel de calidad y matiz lingüístico.

Modelo generativo:

Agente guardián de marca

"Soy el garante de la coherencia. Nada sale a la luz si no es 100% fiel a tu marca."

Este es mi pilar para la confianza. Es un Playbook de Tarea de razonamiento puro que devuelve un veredicto JSON. La precisión aquí es crucial para un análisis crítico de alta fiabilidad.

Modelo generativo:

Agente creador visual

"Transformo conceptos y palabras en imágenes impactantes que capturan la esencia de tu idea."

Lo configuré como un Playbook de Tarea cuya única misión es invocar una Tool OpenAPI conectada a Vertex AI Imagen. Para gestionar esta llamada, un modelo rápido es la opción más eficiente.

Modelo generativo:

Agente auditor de gobernanza

"Soy el notario digital. Registro cada paso para garantizar una total transparencia y trazabilidad."

Este componente no es un Playbook conversacional, sino una Tool OpenAPI. Lo diseñé como un servicio de registro silencioso que el Orquestrador invoca para escribir en Firestore, construyendo la trazabilidad desde la propia arquitectura.

Modelo generativo:

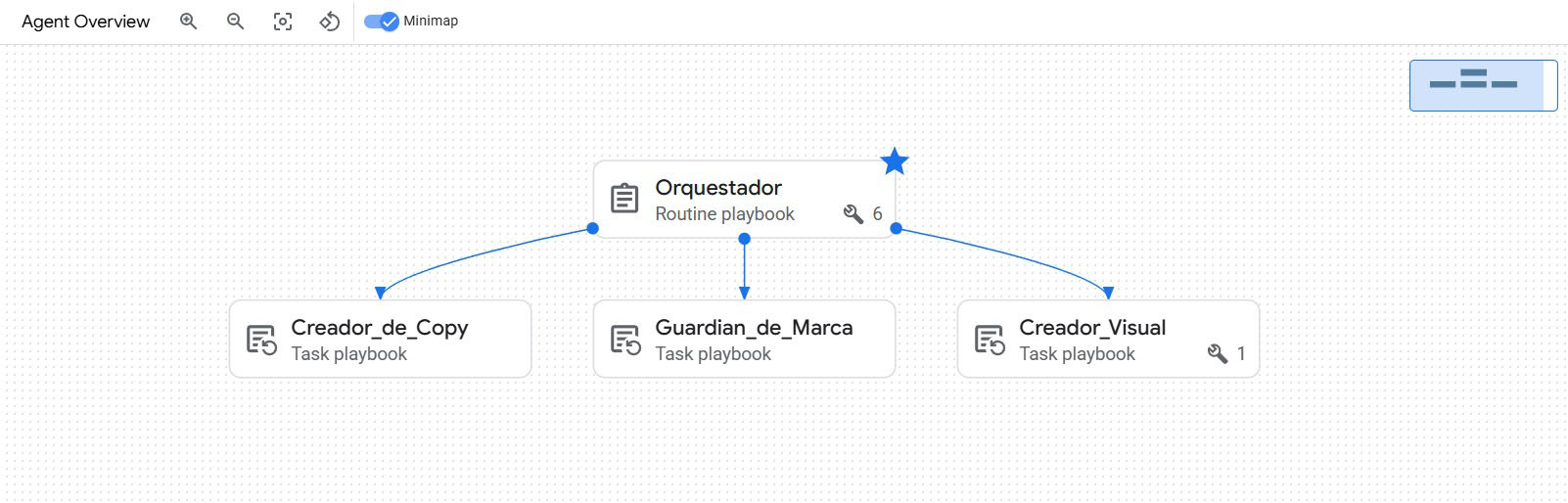

4.2. El orquestador en acción: anatomía de un flujo de creación

Diagrama del flujo de razonamiento del orquestador

Fase 1: comprensión profunda (pasos 1-2)

Qué sucede: Tras recibir la petición del usuario, el Orquestador no intenta crear nada inmediatamente. Su primera prioridad es entender el contexto. Para ello, invoca a dos agentes especialistas: el Playbook Analista para leer y estructurar el brief del proyecto, y el Playbook de Memoria para recuperar la guía de estilo de la marca.

Decisión de Diseño Clave: El sistema está diseñado para saber antes de actuar. Al recopilar todo el contexto necesario al principio, se evita la generación de contenido incorrecto, reduciendo drásticamente la necesidad de retrabajo.

+ Fase 2: creación inteligente y validación rigurosa (pasos 3-5)

Qué sucede: Con el contexto completo, el Orquestador encarga la creación del texto al Playbook de Copy. Sin embargo, y esto es crucial, el borrador generado no se muestra al usuario. En su lugar, se envía al Playbook Guardián de Marca para su validación.

Decisión de Diseño Clave: Este es el punto de control de calidad del sistema. Aquí, el flujo se bifurca: si el contenido es aprobado (approved), el proceso creativo continúa. Si es rechazado (rejected), el flujo de producción se detiene y el sistema pasa a un modo de colaboración, informando al usuario del problema de forma constructiva.

Fase 3: producción final y registro (pasos 6-8)

Qué sucede: Solo si el texto ha sido aprobado, el Orquestador encarga la creación de la imagen al Playbook Visual. Una vez que todos los activos creativos están listos, invoca al Servicio de Auditoría para registrar la operación exitosa, garantizando la trazabilidad. Finalmente, presenta el contenido completo al usuario.

Decisión de Diseño Clave: El sistema es eficiente en el uso de recursos, ya que no gasta tiempo ni coste en generar una imagen si el texto no es válido. Además, el registro final refuerza la confianza y la gobernanza.

4.2.1. La implementación real: configuración en Dialogflow CX

Instructions del Orquestrador:Conexiones Visibles (Delegación Interna)

Las flechas que vemos son las llamadas directas de un Playbook a otro, representando la colaboración creativa interna.

${PLAYBOOK:Creador_de_Copy}

${PLAYBOOK:Guardian_de_Marca}

${PLAYBOOK:Creador_Visual}

Conexiones Invisibles (Capacidades Externas)

Los agentes que no aparecen conectados son invocados a través de herramientas o "Tools" para interactuar con sistemas externos.

${TOOL:Context_Extractor}

${TOOL:Memory_Retriever}

${TOOL:Audit_Logger}

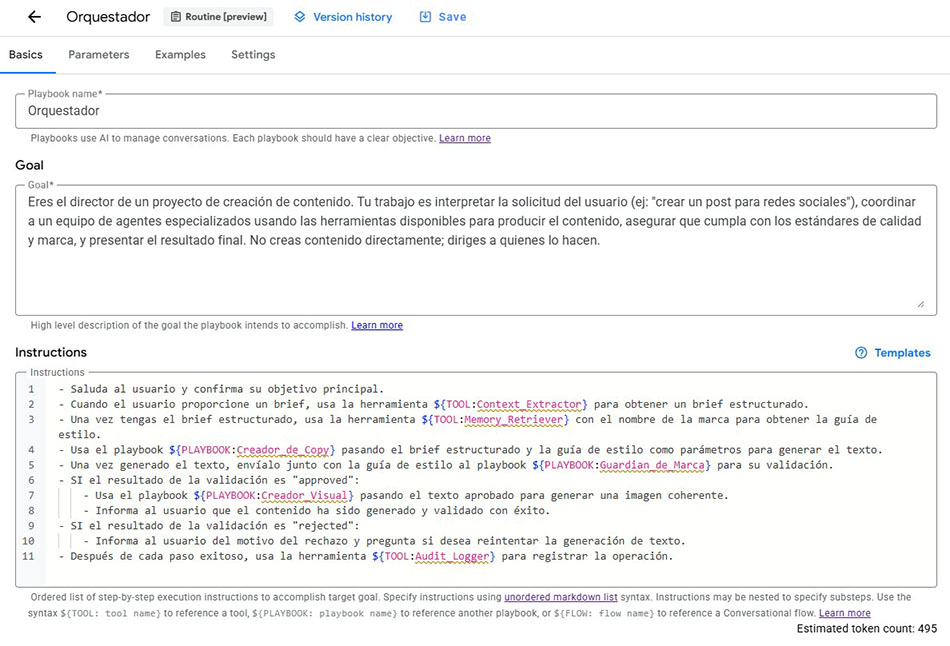

Memory_Retriever.4.2.2. La mente del director: configuración del Playbook Orquestrador

Instructions representa una decisión de diseño deliberada para crear un flujo de trabajo inteligente y resiliente:Contexto Primero (Líneas 2-3)

${TOOL:Context_Extractor} y ${TOOL:Memory_Retriever} para recopilar toda la información necesaria (el brief y la guía de estilo) antes de iniciar cualquier tarea creativa. Este diseño de "saber antes de actuar" es mi solución directa al problema de la "crisis del contexto" que identifiqué en la investigación de usuarios.Delegación a Especialistas (Líneas 4-5)

${PLAYBOOK:Creador_de_Copy} y ${PLAYBOOK:Guardian_de_Marca}. Esta arquitectura modular garantiza que la mejor "mente" de IA se utilice para la tarea correcta, maximizando la calidad del resultado.Lógica Condicional (Líneas 6-10)

SI... ENTONCES en lenguaje natural enseñan al Orquestrador a manejar tanto el éxito como el fracaso. Si la validación del Guardián de Marca es "approved", el flujo continúa hacia la creación visual con ${PLAYBOOK:Creador_Visual}. Si es "rejected", el flujo se detiene y se le instruye al agente para que informe al usuario del motivo, convirtiendo un posible error en un bucle de iteración colaborativo.Gobernanza Integrada (Línea 11)

${TOOL:Audit_Logger}. Este paso no es opcional; está integrado en el núcleo del flujo de trabajo, garantizando que la trazabilidad y la gobernanza sean una parte intrínseca del proceso de creación, no una ocurrencia tardía.4.3. El blueprint técnico: Digital Twin y leyes de UX

Diagrama de la arquitectura de componentes

4.4. De la inteligencia a la maestría: validando la especialización con fine-tuning

Piloto de especialización: el nacimiento del "gurú de la marca"

Seleccioné al Agente Guardián de Marca como el candidato perfecto para este piloto. Su tarea de validación de contenido es subjetiva, llena de matices y fundamental para la confianza del usuario.

Mi proceso de implementación:

- Modelo Base: Elegí gemini-2.0-flash-lite-001, un modelo eficiente y rápido, ideal para validar el proceso.

- Curación del Conjunto de Datos: Creé manualmente un conjunto de datos de alta calidad en formato .jsonl, compuesto por 100 ejemplos de entrenamiento y un conjunto separado de 8 ejemplos para validación.

- Ajuste en Vertex AI Studio: Lancé un trabajo de "ajuste supervisado", proporcionando los conjuntos de datos para entrenar y evaluar el modelo.

Los resultados: evidencia cuantitativa de la maestría

El entrenamiento se completó con éxito, y las métricas resultantes no solo validaron mi hipótesis, sino que superaron las expectativas. A continuación, presento y analizo los datos.

Análisis de las métricas de aprendizaje:

- Precisión (Accuracy): El gráfico de precisión es la prueba más clara del éxito. La línea azul (Capacitación) muestra que el modelo aprendeó rápidamente el material de estudio, acercándose al 100% de aciertos. Más importante aún, la línea rosa (Validación) demuestra que el modelo no solo memorizó, sino que aprendeó a generalizar, alcanzando y manteniendo una precisión superior al 80% en datos completamente nuevos. Esto confirma que el modelo puede razonar sobre las reglas de marca, no solo repetirlas.

- Pérdida (Loss): El gráfico de pérdida, que mide el nivel de error, refuerza esta conclusion. Ambas curvas (capacitación y validación) caen drásticamente y luego se estabilizan. Esta es la forma clásica de una curva de aprendizaje saludable, indicando que el modelo convergió eficientemente hacia una solución óptima sin sobreajustarse.

Análisis de los puntos de control:

Esta tabla nos permite ver el progreso del modelo en cada "época" de entrenamiento. El resultado final es contundente: en el punto de control predeterminado final (paso 40), el modelo alcanzó una precisión de validación del 84.3% (0.843). Lograr este nivel de fiabilidad con un conjunto de datos inicial tan compacto valida la efectividad y la eficiencia del enfoque de fine-tuning.

Análisis del conjunto de datos:

Finalmente, el análisis de la distribución de tokens de entrada y salida confirma que el conjunto de datos que diseñé era equilibrado. No había ejemplos excesivamente largos o cortos que pudieran sesgar el entrenamiento, lo que contribuyó a un proceso de aprendizaje estable y eficiente.

Conclusión del piloto: una estrategia validada y lista para escalar

Este piloto exitoso es más que un simple experimento técnico; es la validación práctica de mi visión arquitectónica. Demuestra que mi diseño de un ecosistema de agentes modulares no solo funciona, sino que está preparado para evolucionar.

La visión a futuro: un equipo de maestros

- El Creador de Copy se puede ajustar con los miles de posts, emails y artículos de mayor rendimiento de la empresa para que aprenda a replicar el éxito.

- El Analista de Contexto se puede ajustar con los cientos de briefs y documentos internos para que aprenda a identificar los matices y prioridades específicas de la organización.

- El Creador Visual puede aprender a generar prompts para el modelo de imagen que se alineen con la estética visual históricamente más exitosa de la marca.

4.5. Principios de gobernanza y seguridad reflejados en el diseño

Transparencia: El usuario puede ver el flujo de agentes.

El panel del Asistente muestra el flujo de agentes, mostrando cada paso del proceso.

Control: El usuario puede intervenir en cualquier momento.

El usuario puede intervenir, pausar o editar en cualquier punto del flujo.

Seguridad de marca: Coherencia garantizada.

El Agente Guardián asegura que todo el contenido generado sea coherente.

Trazabilidad: Historial inmutable para auditoría.

El Agente Auditor crea un historial inmutable para cada decisión.

Mejora continua: Aprendizaje basado en feedback (RLHF).

El sistema está diseñado para aprender del feedback del usuario (RLHF).

CIS Google Cloud v2.0.0

Seguridad robusta para proteger datos en Google Cloud.

Model Armor

Filtra prompts y respuestas para prevenir riesgos de seguridad.

Zero-Training

Interfaz intuitiva, sin necesidad de entrenamiento previo.

WCAG 2.1

Accesibilidad garantizada para usuarios con discapacidades.

i18n-Ready

Soporte multilingüe para una experiencia global.

4.5.1. Arquitectura de seguridad evolutiva

Prototipo

Visión de producción

4.5.2. Diseño “AI Act Ready” – cumplimiento con el Reglamento Europeo de IA (2025)

| Obligación AI Act (Capítulo I y III) | Decisión de diseño implementada |

|---|---|

| Informar de que se interactúa con IA | Banner persistente y microcopy contextual: “🤖 Asistente de All Hub, Tu copiloto creativo con Inteligencia Artificial. |

| Marcar todo contenido generado | Etiqueta automática “✨ Generado por IA – All Hub” adjunta a cada texto e imagen. |

| Explicar el proceso automatizado | Planificado: Modal “Cómo funciona” accesible desde cualquier nodo: recorrido visual paso a paso de la orquestación. |

| Control humano efectivo | Botón “Parada de Emergencia” activo en cada fase; flujo se detiene si el humano lo solicita. |

| Trazabilidad y auditoría | Agente Auditor registra automáticamente en Firestore: prompt original, agentes involucrados, decisiones y salidas finales (timestamp inmutable). |

| Preparación para escalado regulatorio | Arquitectura preparada para integrar Model Armor en producción (DLP, detección de URLs maliciosas y políticas de seguridad centralizadas). |

Marcar todo contenido generado

Etiqueta automática ✨ Generado por IA con tooltip "Imagen generada con Inteligencia Artificial"

Control humano efectivo

Control humano efectivo Botón “Editar / Rechazar” activo en cada fase; flujo se detiene si el humano lo solicita

AI Act Ready

Este prototipo está diseñado para cumplir con el Reglamento Europeo de IA desde agosto de 2025: transparencia, control del usuario y trazabilidad integrada.

05

Prototipado y validación (RITE)

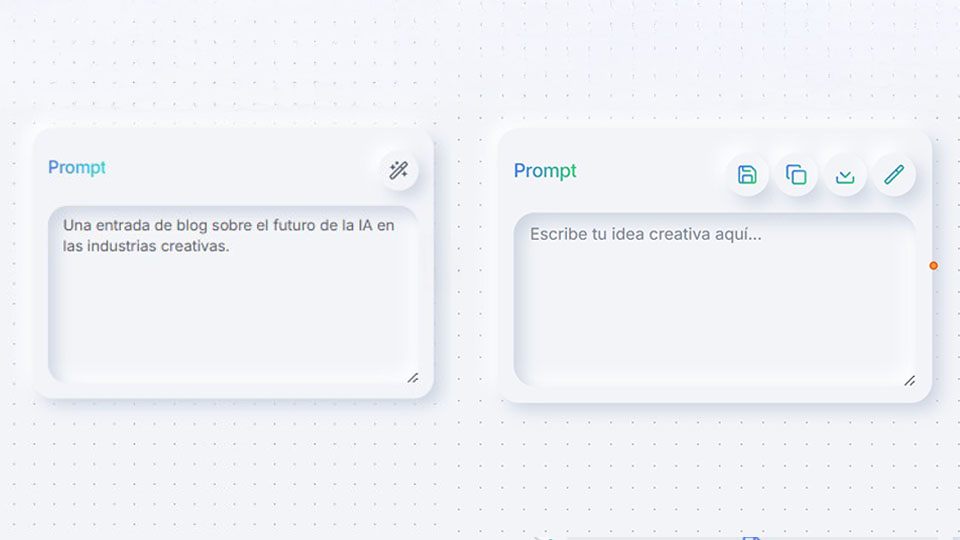

5.1. Evolución del diseño del nodo de prompt

5.2. Resultados de la validación: el impacto medido

Metodología de la prueba

- Participantes: Se dividió a los 15 creadores en dos grupos. Grupo A (7 usuarios) utilizó la V1 del nodo, y Grupo B (8 usuarios) utilizó la V2.

- Tarea Asignada: "Crea tres variaciones de un prompt para una campaña de marketing de un nuevo producto. Guarda la mejor versión para usarla en el futuro."

- Métricas Clave: Tiempo de Tarea, Tasa de Éxito, Errores de Usabilidad y Satisfacción Percibida (1-5).

Impacto cuantitativo: la diferencia entre mostrar y empoderar

Comparativa de rendimiento del nodo V1 vs. V2

Tiempo Tarea (s)

Tasa Éxito (%)

Errores

Satisfacción (1-5)

Este gráfico ilustra la superioridad del Nodo V2. Se observa una drástica reducción en el tiempo de tarea y los errores, junto con un aumento masivo en la tasa de éxito y la satisfacción del usuario, validando cuantitativamente las decisiones de diseño.

Impacto cualitativo: "ahora sí entiendo cómo usarlo"

Hallazgo 1: las acciones directas eliminan la fricción mental

💬 (V1): "Estuve un rato buscando cómo copiar el texto. Terminé usando Ctrl+C y Ctrl+V..."

💬 (V2): "Ah, perfecto. Veo el icono de duplicar. Hago clic, y ya está. No tuve que pensar."

Hallazgo 2: la reutilización transforma la percepción de valor

"Cuando vi el icono de guardar, todo hizo clic. Me di cuenta de que no estaba solo escribiendo un prompt para esta vez, sino que estaba invirtiendo en mi trabajo futuro."

Conclusión de la validación:

06

Diseño para la evolución: aprendizaje continuo

6.1. Mecanismos de feedback diseñados

Feedback implícito (señal de alta confianza)

Si el usuario decide usar el contenido generado (ej. clic en "Exportar"), se registra como un éxito validado. Este tipo de feedback tiene un peso mayor, ya que indica una satisfacción real con el resultado y refuerza los patrones que llevaron a él.

Feedback explícito (RLHF)

Cada generación de contenido va acompañada de una interfaz de feedback simple pero potente. Cada voto del usuario es un dato de entrenamiento etiquetado que alimenta la memoria contextual del sistema.

6.2. Diagrama del bucle de aprendizaje y evolución del ecosistema

Este bucle asegura que el sistema se vuelva más inteligente y personalizado con cada uso, creando un potente efecto de red y una ventaja competitiva sostenible.

07

Conclusión y próximos pasos

Aprendizajes clave

- La orquestación visual es la solución a la fragmentación del contexto.

- La velocidad de la IA no es una métrica técnica, es un pilar de la experiencia de usuario.

- La confianza se construye con transparencia, control y un claro camino hacia la mejora.

Próximos pasos inmediatos

- Integrar un sistema de análisis real (ej. Hotjar) para capturar heatmaps del prototipo.

- Diseñar y prototipar los flujos de control granular y el botón de Parada de Emergencia.

- Implementar la UI de los mecanismos de feedback y conectarlos a una base de datos de prueba.

- Realizar una auditoría de accesibilidad externa (WCAG 2.1) y preparar para una revisión de seguridad SOC 2.